OpenAI、GoogleのAIチップを初採用

米OpenAIが、これまで主力としてきたNVIDIA製GPUではなく、Google(親会社Alphabet)開発のAI半導体「TPU(テンソル・プロセッシング・ユニット)」を借用し、ChatGPTなど自社製品に導入を開始した。

この動きは、ニュースサイトのジ・インフォメーションが複数の関係者の話として27日に報じた。

OpenAIはこれまで、NVIDIAのGPUを中心にAIモデルの学習や推論に対応してきた。特にChatGPTの大規模な演算処理では、NVIDIAのH100やA100といった高性能チップが利用されていた。

しかし、AI需要の急増により演算リソースの確保が逼迫。コスト面や供給の安定性が課題となっていた中で、今回のTPU採用は注目を集めている。

TPUとは何か? Googleが開発したAI向け専用チップ

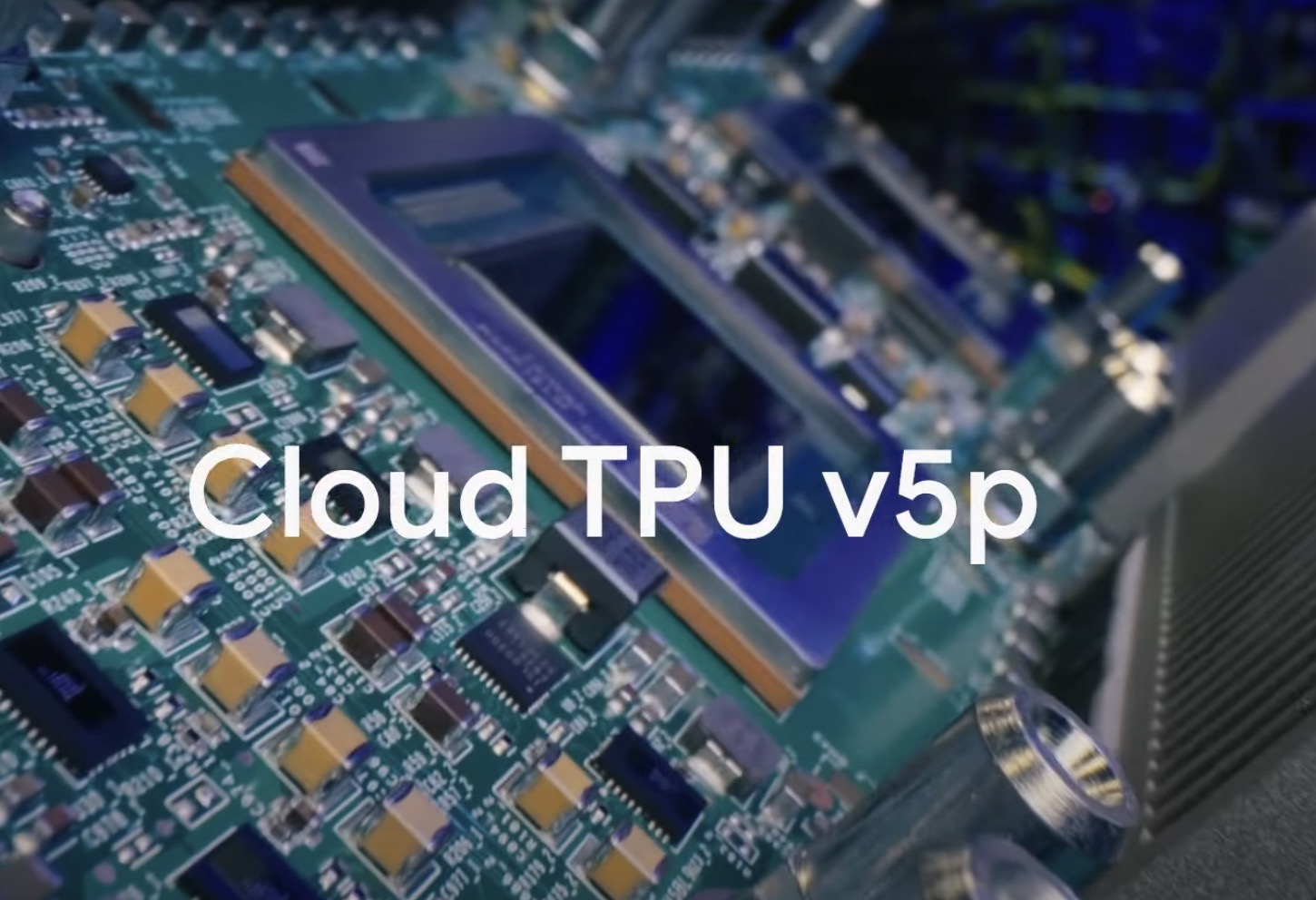

TPUは、Googleが2015年から開発を開始し、2016年に初公開されたAI専用の半導体チップである。

その後も世代を重ねて進化を遂げており、2025年現在では第7世代「TPU v7(Ironwood)」まで登場している。

TPUはトレーニングと推論の両方で使用可能であり、従来のGPUに比べてコストパフォーマンスが高い点が特徴だ。

クラウド経由での利用が可能で、Google Cloud Platform(GCP)を通じて提供されている。

インフラの多様化と推論コスト削減が狙い

OpenAIは、クラウド事業者として提携しているマイクロソフトのAzureを主な演算基盤としてきたが、今回のTPU導入により、インフラの多様化を進める姿勢を見せた。

ジ・インフォメーションによると、TPUは推論用途での利用を想定しており、OpenAIはこれにより演算コストを大幅に削減できると見込んでいる。

ただし、Googleは最高性能のTPUについては引き続き社内専用としており、競合企業への外部提供には慎重な姿勢を保っている。

今後のAI半導体競争に新展開も

これまでAI学習用チップ市場ではNVIDIAが90%以上のシェアを占める圧倒的リーダーだった。

しかし、Google、Amazon、Microsoftなどの大手クラウドプロバイダーが独自チップを次々と発表し、代替エコシステムの構築を進めている。

今回のOpenAIによるTPU導入は、その流れを象徴する一例であり、AI半導体競争の新たな局面を迎えつつある。

AI需要が今後さらに高まる中で、どの半導体アーキテクチャが主流となるかは、技術性能だけでなく、コスト、供給、エコシステムの柔軟性など多面的な要素が鍵を握る。